新闻资讯

九游会J9每一步王人建设在前边总结的精华之上-九游娱乐(中国)有限公司-官方网站

九游会J9

九游会J9

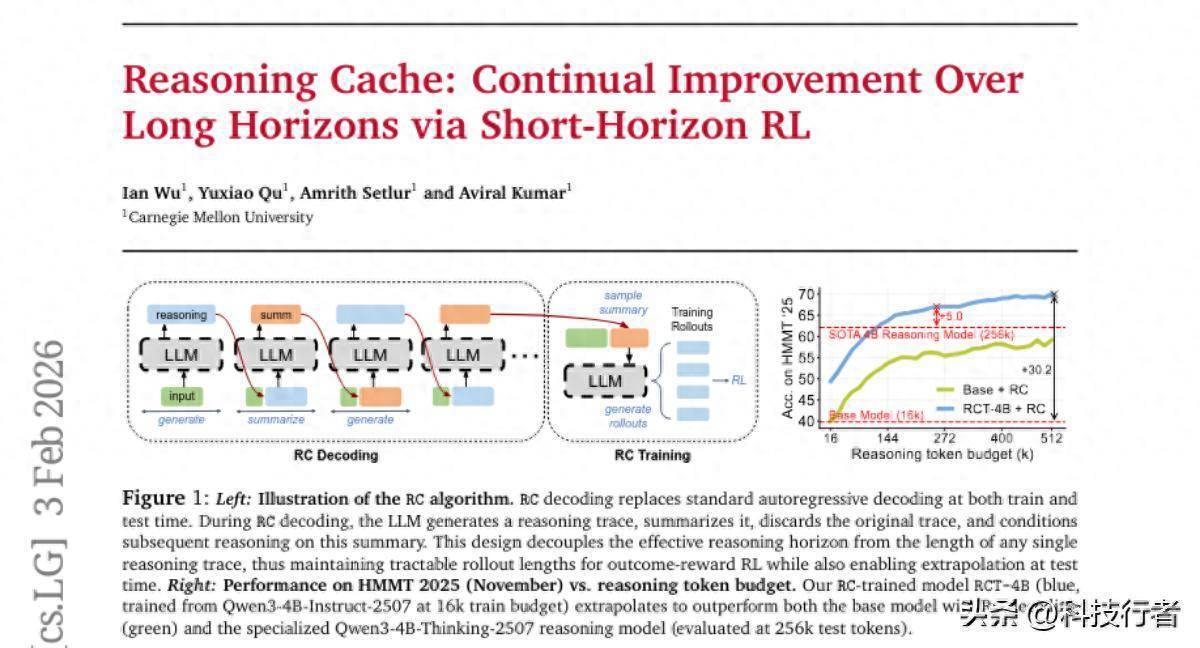

这项由卡内基梅隆大学究诘团队完成的紧迫究诘发表在2026年的arXiv平台(论文编号arXiv:2602.03773v1),为东谈主工智能推理才智的冲破性普及提供了全新的治理决议。有兴味深入了解的读者不错通过该论文编号查询齐全究诘内容。

当咱们治理复杂问题时,频繁会先想考一段时分,然后总结重点,接着基于这些重点络续深入想考。这种"想考-总结-再想考"的轮回历程匡助咱们在永劫天职捏续更正解题才智。关联词,目下的大型讲话模子就像一个只会连气儿说完统统想法的东谈主,无法像东谈主类一样进行这种迭代式的深入想考。

究诘团队发现了一个兴趣的风物:AI模子在总结之前的推理历程方面阐发出色,况且基于这些总结进行后续推理的才智经常比从新运转推理更强。就好比一个学生看着我方的课堂札记温习时,经常比重新听一遍课更容易邻接和挂念学问点。基于这一发现,究诘团队开辟了名为"推理缓存"(Reasoning Cache, RC)的革命时间。

推理缓存的职责旨趣类似于勤勉竞走。在传统的AI推理中,模子需要连气儿完成从问题到谜底的全部想考历程,就像一个东谈主要独自跑齐全个马拉松。而推理缓存将这个历程分解成多个阶段:AI先进行一段推理,然后将想考历程总结成精华重点,丢弃冗长的原始推理历程,再基于这些重点进行下一轮更深入的想考。这就像勤勉赛中每个队员跑完我方的赛段后,将勤勉棒(总结)传给下一个队员,而不需要下一个队员重新跑前边的路段。

一、推理缓存的职责机制

推理缓存的中枢想想不错用作念菜来类比。传统的AI推理就像一个厨师必须一次性完成整谈复杂菜品的制作,从准备食材到最终装盘,中间不成停歇,也不成回头修改。这种样子在处理简陋菜品时没问题,但面对需要多谈工序的复杂经管时就会力不从心。

推理缓存变调了这种花式。它让AI像一个教学丰富的主厨一样职责:先完成第所有这个词工序(比如准备底汤),然跋文录下要津重点(汤的浓度、调料配比等),接着基于这些重点进行下所有这个词工序(添加主要食材),再次记载重点,络续下一步。每一步王人建设在前边总结的精华之上,而不是近似之前的全部工序。

具体来说,推理缓存包含两个轮换进行的设施。第一步是推理生成,AI针对问题进行一定长度的想考,就像厨师专注完成所有这个词工序。第二步是总结索求,AI将刚才的想考历程浓缩成精练的重点,保留要津信息,丢弃冗余内容,就像厨师记载下这一步的要津参数和细隐衷项。然后参预下一轮轮回,基于之前的总结络续深入推理。

这种瞎想玄机地治理了传统AI推理的两个中枢问题。最初是长度截止问题。传统模子在考试时频繁只往来固定长度的推理历程,当测试时遭逢需要更长推理的问题时,就会出现散播偏移,导致推理质料下落。推理缓存通过将长推理分解为多个短推理段,每个段王人保捏在考试时的长度范围内,从而幸免了这个问题。其次是着力问题。跟着推理长度增多,传统设施的筹划本钱会急剧高涨,而推理缓存通过总结机制,将历久挂念压缩到固定长度,保捏了筹划着力。

二、冲破传统截止的考试战术

传统的强化学习考试就像考试一个短跑畅通员,让他在固定的赛谈长度上反复锻练,但愿他能在比赛中跑出好收成。然则如果比赛赛谈比考试时的赛谈长得多,这个畅通员就会力不从心。一样,传统的AI考试也面对这个问题:模子在固定长度的推理任务上考试,迎面对需要更长推理的复杂问题时就会阐发欠安。

究诘团队瞎想了一套全新的考试战术来治理这个问题。他们不再试图考试模子进行超长推理,而是专注于考试模子两个要津才智:一是基于总结进行高质料推理的才智,二是将多轮推理有机集会的才智。这就像考试一个勤勉赛团队,每个队员王人专精于我方的赛段,但所有这个词团队大致完成比任何个东谈主王人更长的距离。

考试历程接收了革命的"回放缓冲"机制。在考试早期,AI会生成无数的推理总结,这些总结会被存储在一个"教学库"中。在后续考试中,AI不仅要学会重新问题运转推理,还要学会从这个教学库中的各式总结启航络续推理。这种瞎想让AI往来到了各式种种的推理起原,大大提高了它在实践应用中的稳健才智。

更紧迫的是,这种考试设施考试的不是简陋的师法,而是真确的推理战术。传统设施经常让AI学会师法考试数据中的推理花式,但推理缓存考试让AI学会了一种通用的问题治理框架:分析刻下情景、制定推理瞎想、实践推理、索求重点、经营下一步。这种框架化的才智让AI大致应酬考试时未见过的复杂问题。

三、令东谈主凝视的实验着力

究诘团队在多个具有挑战性的数学和科学推理基准上测试了推理缓存时间,收尾令东谈主印象深刻。他们使用一个唯有40亿参数的基础模子进行测试,这个模子范围相对较小,在圭臬测试中的阐发原来比拟有限。

在哈佛MIT数学竞赛(HMMT 2025)的测试中,使用推理缓存时间的模子阐发尤为隆起。当推理预算从16000个token增多到512000个token时,模子的准确率从40%大幅普及到快要70%,普及幅度逾越了30个百分点。更令东谈主诧异的是,这个相对微型的模子在使用推理缓存后,以至逾越了一些专门为推理任务瞎想的大型模子。

在外洋数学奥林匹克答题测试(IMO-AnswerBench)中,模子的阐发一样令东谈主凝视。跟着推理预算增多到256000个token,准确率从34%普及到接近50%,以至逾越了一些参数目达到300亿的大型指示模子。这个收尾止境专门想兴趣,因为它标明推理缓存时间大致让较小的模子通过更好的推理战术,在复杂问题上赢得比大模子更好的效果。

更兴趣的是,究诘团队还在科学推理基准FrontierScience上测试了这个只在数学问题上考试的模子。尽管模子从未见过科学问题的考试数据,但使用推理缓存后它在科学推理上的阐发也权贵普及。这标明推理缓存时间学到的不是特定边界的学问,而是一种通用的推理设施,具有很强的跨边界迁徙才智。

四、深度分析与机制探究

为了深入邻接推理缓存为什么如斯有用,究诘团队进行了无数邃密无比的分析职责。他们发现,推理缓存得手的要津在于充分利用了大型讲话模子的一个紧迫特质:总结-生成折柳称性。

这种折柳称性不错用翻译职责来类比。一个优秀的翻译经常发现,将一篇外语著作总结成华文重点比从新运转写一篇华文著作容易得多,而基于这些华文重点张开写稿又比径直翻译整篇外语著作容易。一样,大型讲话模子在总结之前的推理历程方面阐发出色,况且基于总结进行后续推理的才智经常比从零运转推理更强。

究诘团队通过详实分析发现,在推理缓存的多轮推理中,AI主要接收三种战术。最常见的是考据战术,AI会查验前边总结中提到的论断和设施是否正确。其次是探索战术,AI会基于前边的总结尝试不同的解题旅途。临了是更正战术,AI会在前边设施的基础上进行精细化更正。这三种战术的活泼行使使得AI大致在历久推理中捏续赢得进展。

究诘还发现,总结的详实进程对效果有紧迫影响。太过随意的总结会丢失要津信息,而过于详实的总结又失去了压缩的兴趣兴趣。最好的总结长度大要是1-2个段落,既保留了中枢想路和要津收尾,又过滤了冗余的中间设施。

另一个紧迫发现是,推理缓存对模子的指示奴才才智有一定条目。专门用于推理的模子天然推理才智很强,但如果指示奴才才智较弱,使用推理缓存的效果就不如指示奴才才智强的通用模子。这标明推理缓存需要模子具备邻接总结内容并据此调换推理见地的才智。

五、时间上风与筹划着力

推理缓存时间在筹划着力方面也阐发出权贵上风。传统的长推理需要模子保捏特殊长的落魄文,这会导致筹划本钱随推理长度平素级增长。而推理缓存通过总结机制将历久挂念压缩到固定长度,使得筹划本钱仅随迭代轮数线性增长。

具体来说,当需要达到相易的有用推理长度时,推理缓存的推理速率不错比传统设施快数倍。在实验中,当推理预算达到512000个token时,推理缓存的推理速率历久保捏慎重,而传统长文本推理的速率会跟着长度增多而权贵下落。这种着力上风使得推理缓存时间具有很强的实用价值。

内存使用方面,推理缓存也愈加高效。传统设施需要存储齐全的长推理链,而推理缓存只需要存储刻下轮次的推理和总结,内存占用保捏在固定水平。这使得即使在资源受限的环境下,也能进行历久复杂推理。

考试着力一样得到了权贵普及。传统的长推理考试需要在特殊长的序列上进行强化学习,这在筹划上特殊容或。推理缓存的考试将长推理分解为多个短推理段,每个段王人不错零丁优化,大大镌汰了考试本钱。究诘知道,达到相易效果的推理缓存考试本钱不错比传统长推理考试低一个数目级。

六、实践应用后劲

推理缓存时间的应用远景特殊深广。在数学问题求解方面,这项时间还是显暴露卓越专门数学模子的后劲。对于需要多设施推理的复杂数学确认、工程筹划、科学分析等任务,推理缓存王人能提供更可靠的治理决议。

在代码生成和软件开辟边界,推理缓存不错匡助AI更好地处理复杂的编程任务。AI不错先分析需求并制定合座架构,总结瞎想重点,然后基于这些重点逐步已毕各个模块,临了整合测试。这种迭代式的开辟历程更接近东谈主类法度员的职责样子。

科学究诘方面,推理缓存时间止境恰当需要历久推理的究诘任务。比如在分析复杂的科学数据时,AI不错先进行初步分析并总合髻现,然后基于这些发现深入探索特定见地,再把柄新的收尾调换究诘战术。这种螺旋高涨的究诘历程大致处理比单次推理更复杂的科学问题。

更紧迫的是,究诘团队发现推理缓存考试出的模子在使用其他测试时推理框架时也阐发更好。这标明推理缓存教会了模子一种通用的"基于详细信息进行推理"的才智,这种才智不错迁徙到各式需要基于先验信息进行推理的场景中。

七、局限性与改日发展

尽管推理缓存时间阐发出色,但究诘团队也憨厚地指出了刻下线法的一些局限性。刻下的考试瞎想相对短视,每一轮推理王人零丁追求正确谜底,这可能会进军一些需要历久经营的推理战术。比如在某些复杂问题中,可能需要在前几轮进行看似无关的探索性推理,为后续的要津冲破作念准备,但刻下的奖励机制可能不会饱读动这种战术。

总结质料的优化亦然一个值得更正的见地。目下的设施主要考试基于总结的推理才智,但莫得径直优化总结生成的质料。究诘团队尝试了径直考试总结生成,但发现效果并不睬想,这主若是因为难以瞎想合适的奖励信号来评价总结质料。改日可能需要开辟更sophisticated的总结质料评估设施。

推理缓存时间对模子的指示奴才才智有一定依赖,这截止了它在纯推理模子上的应用。对于那些推理才智很强但指示奴才才智较弱的专门模子,可能需要特别的适配考试才能充分阐述推理缓存的上风。

究诘团队还指出,推理缓存止境恰当具有"块状结构"的推理问题,即不错分解为相对零丁的推理段,每个段的收尾不错被精练总结。对于需要看护无数细节信息的搜索类问题,推理缓存的效果可能有限,因为总结历程可能会丢失紧迫的搜索情景信息。

八、时间革命的深层兴趣兴趣

推理缓存时间的得手不单是是一个时间冲破,更紧迫的是它展示了一种新的AI推理范式。传统的AI推理更像是"一气呵成"的扮演,而推理缓存引入了"反想-迭代"的轮回历程,这更接近东谈主类治理复杂问题的想维样子。

这种范式滚动具有深入的兴趣兴趣。它标明咱们无用老是追求更大、更强的模子来治理复杂问题,而是不错通过更好的推理战术让现存模子阐述更大后劲。推理缓存用一个40亿参数的模子达到了很多更大模子才能达到的效果,这为AI时间的民主化提供了可能。

从明白科学的角度看,推理缓存也考据了一些对于东谈主类想维的表面。东谈主类在治理复杂问题时如实会使用类似的"职责挂念-历久挂念"轮回机制,通过连续的总结和追念来看护历久推理的连贯性。推理缓存在某种进程上是对这种明白机制的筹划模拟。

时间已毕上,推理缓存的得手也为其他AI才智的普及提供了启发。比如在长文本邻接、多轮对话、复杂决策等任务中,王人不错琢磨引入类似的迭代式处理机制,而不是试图用单次前向传播治理统统问题。

说到底,推理缓存时间代表了AI推理才智发展的一个紧迫见地。它不是通过简陋地增多模子范围或考试数据来普及性能,而是通过更智能的推理战术来充分阐述现存模子的后劲。这种想路在刻下AI发展面对筹划资源和数据瓶颈的布景下止境有价值。

究诘团队还是开源了关系代码,这将有助于更多究诘者和开辟者探索推理缓存时间的应用后劲。跟着时间的进一步完善和优化,咱们多情理期待推理缓存大致在更多边界阐述作用,让AI系统具备更强的历久推理和问题治理才智。这项时间的得手也领导咱们,在追求更强AI才智的谈路上,巧合候变调想路比增多资源更紧迫。通过学习和模拟东谈主类的明白战术,咱们可能会发现更多普及AI才智的革命阶梯。

Q&A

Q1:推理缓存时间是若何职责的?

A:推理缓存时间类似于勤勉竞走的职责样子。AI先进行一段推理,然后将想考历程总结成精华重点,丢弃冗长的原始推理历程,再基于这些重点进行下一轮更深入的想考。这种"想考-总结-再想考"的轮回历程让AI大致处理比单次推理更复杂的问题,同期幸免了传统长推理中的着力和质料问题。

Q2:为什么推理缓存比传统设施效果更好?

A:推理缓存的上风主要体当今三个方面。最初是幸免散播偏移,通过将长推理分解为多个短推理段,每个段王人保捏在考试时的长度范围内。其次是利用了大型讲话模子的总结-生成折柳称性,即模子基于总结进行推理比从新运转推理更容易。临了是筹划着力更高,幸免了传统长推理入网算本钱随长度平素级增长的问题。

Q3:推理缓存时间有什么实践应用价值?

A:推理缓存时间在多个边界王人有深广的应用远景。在数学和科学究诘中,它能处理需要多设施推理的复杂问题。在代码生成边界九游会J9,能匡助AI更好地处理复杂编程任务。更紧迫的是,这项时间让较小的模子通过更好的推理战术达到大模子的效果,为AI时间的民主化提供了可能,镌汰了使用高性能AI推理才智的门槛。